Ogni volta che ascolto qualcuno che parla dell’uso dell’Intelligenza Artificiale in azienda mi sembra che stiano trattando un tema ormai annoso e, invece, siamo solo agli inizi. Ma la fretta di implementare tecnologie arrivate a disposizione del business praticamente ieri è tale che ognuno trova un pezzetto che si dovrebbe far meglio e, a volte, questo pezzetto è addirittura alle fondamenta dell’implementazione. Durante una chiacchierata con Axiante, azienda specializzata anche in soluzioni di AI per il business, è emerso che le aziende italiane sono adesso orientate a superare la fase iniziale di entusiasmo legata all'intelligenza artificiale (AI) per concentrarsi sulla traduzione di queste tecnologie in impatti concreti sull'efficienza operativa e sul fatturato. Secondo loro, questo passaggio richiede una riflessione profonda su un elemento spesso dato per scontato: la gestione dei dati. Nonostante l'enorme risonanza dell'AI in ogni ambito, esiste il rischio concreto che il suo fondamento cardine, ovvero una gestione approfondita dei dati, venga messo in secondo piano rischiando di compromettere il risultato finale.

Il legame tra l'enorme mole di informazioni generate quotidianamente (Big Data) e l'intelligenza artificiale è intrinseco. I Big Data forniscono il volume di informazioni che l'AI elabora e interpreta, fungendo da carburante essenziale che consente alle organizzazioni di analizzare modelli, riconoscere tendenze e prendere decisioni informate, persino in tempo reale e in modo automatico. Questo permette di personalizzare l'esperienza dei clienti, ottimizzare le operazioni e migliorare continuamente la precisione e le prestazioni dei sistemi AI.

Parallelamente, l'AI eleva la capacità di organizzare, elaborare e analizzare questi dati a livelli prima impensabili, aprendo nuove vie per estrarre informazioni utili e alimentare ulteriori sistemi di intelligenza artificiale. Tuttavia, la gestione di set di dati così vasti attraverso l'AI solleva sfide significative in termini di cybersecurity, rispetto della privacy e conformità normativa.

La prospettiva nel nostro Paese

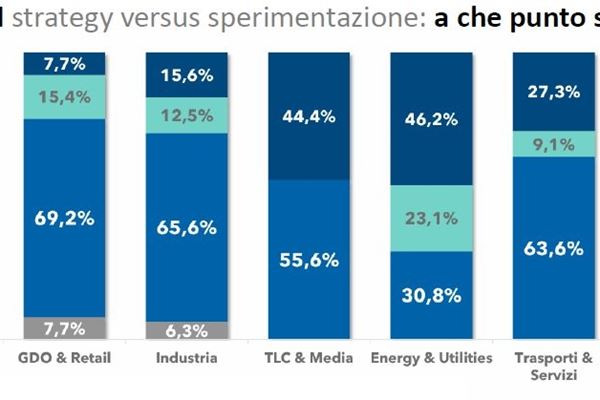

In Italia, sebbene milioni di individui utilizzino l'AI quotidianamente, le aziende si avvicinano a questa tecnologia con una certa cautela. Come osserva Romeo Scaccabarozzi, AD di Axiante, le medie e grandi imprese che hanno pienamente integrato l'AI nella strategia sono ancora poche. Questa prudenza non deriva necessariamente da sfiducia o immaturità, ma rispecchia un pattern già osservato con altre innovazioni tecnologiche: le aziende richiedono concretezza, applicazioni pertinenti al proprio contesto e chiari ritorni sull'investimento (ROI) prima di adottare una novità significativa.

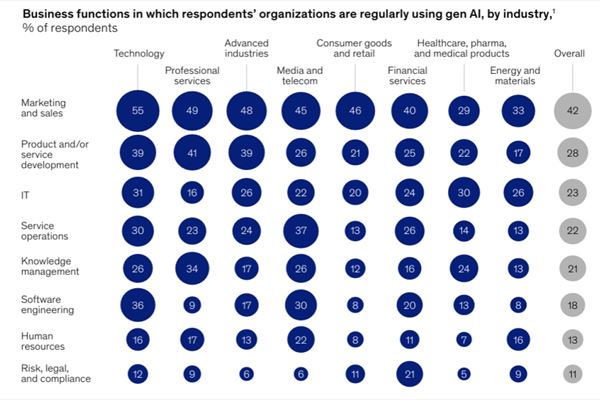

L'AI non ha ancora raggiunto la piena maturità in tutti questi ambiti. Di conseguenza, la maggior parte delle aziende italiane è in una fase di valutazione e sperimentazione, concentrandosi su progetti pilota (Proof-of-Concept - POC), attualmente soprattutto nei settori vendite, marketing, sviluppo prodotti/servizi, IT e operations. Il predominio delle vendite e del marketing è significativo, essendo un'area dove le aziende investono consistentemente ma spesso raccolgono meno del previsto.

Qui, l'AI promette di aiutare a conseguire obiettivi difficili da centrare in passato, come una personalizzazione profonda del rapporto con il cliente, l'incremento della fedeltà e l'espansione della quota di mercato. L'adozione diffusa dell'AI è vista, tra l'altro, come una grande opportunità per le imprese italiane per affrontare il loro storico problema di bassa produttività.

Il Paradosso della Scarsità di Dati e l'Ascesa dei Dati Sintetici

Nonostante l'enorme volume di dati generato ogni giorno, uno dei maggiori ostacoli per lo sviluppo di soluzioni AI efficaci è il paradosso della carenza di set di dati reali consistenti e di alta qualità nelle giuste quantità. Ottenerli diventa sempre più arduo a causa di nuove problematiche legate alla privacy, restrizioni legali, un naturale decadimento della rilevanza nel tempo e i costi elevati associati all'acquisizione e alla catalogazione dei dati. Questa sfida è in crescita anche a causa della crescente sofisticazione dei modelli AI, che richiedono dataset sempre più ampi e specifici.

In questo contesto, un elemento cruciale per superare i limiti dei dati reali è rappresentato dai dati sintetici. Si tratta di dati veri e di alta qualità che sono stati sottoposti a un processo di anonimizzazione o di integrazione. L'obiettivo è utilizzare questi dati come sostituti validi o integrazioni ai dataset completi, soprattutto quando questi ultimi sono insufficienti, troppo costosi o non disponibili per ragioni di privacy.

La crescente domanda di dati di qualità per alimentare l'AI e il machine learning non solo sta stimolando lo sviluppo di soluzioni per la generazione di dati sintetici, ma sta anche modificando la percezione della loro qualità. Quelli che un tempo potevano essere associati a una "qualità inferiore" sono ora riconosciuti come un'alternativa o un'integrazione efficace. Si prevede che il loro utilizzo aumenterà drasticamente: secondo una stima di Gartner, nel 2024 oltre la metà dei dati impiegati per l'AI e il machine learning era già sintetica, e questa percentuale potrebbe superare il 90% entro il 2030.

Sebbene la generazione di dati sintetici non sia una novità assoluta, le tecniche si sono evolute significativamente. Oggi, l'AI stessa può contribuire a replicare con precisione le caratteristiche statistiche dei dati originali. Tra le tecniche impiegate vi sono le simulazioni basate su modelli matematici, la data augmentation, modelli generativi avanzati come GANs e VAEs, l'uso di Large Language Models per generare testo e dialoghi, generatori specifici per dati strutturati (tabellari) e generatori basati su regole definite. Un passaggio fondamentale per garantire la qualità dei dati sintetici è il data profiling, un'analisi sistematica dei dati reali di partenza per comprenderne struttura, distribuzioni e relazioni. Questa fase è vitale per assicurare che i dati sintetici riflettano fedelmente le caratteristiche del mondo reale e non introducano distorsioni. Axiante, lavorando spesso con dati tabellari, sottolinea come la generazione di questi set sintetici richieda forti competenze per evitare di amplificare i problemi presenti nei dataset reali iniziali.

Applicazioni Concrete dell'AI e dei Dati Sintetici nel Business

La generazione di dati sintetici si rivela particolarmente utile in progetti chiave per le aziende, come le Customer Data Platform (CDP) e la Customer Intelligence (CI), aree molto richieste specialmente nei settori retail, bancario, assicurativo e sanitario. Queste iniziative mirano a raggiungere un elevato livello di personalizzazione delle offerte e a gestire i dati in conformità con le normative sulla privacy.

La CDP unifica e organizza i dati del cliente provenienti da diverse fonti, mentre l'AI gioca un ruolo cruciale nell'identity resolution, ovvero nel riconciliare i dati della stessa persona per creare un profilo unico. La Customer Intelligence, invece, analizza i dati raccolti dalla CDP per estrarre insight strategici – prevedere comportamenti, ottimizzare campagne, ridurre l'abbandono – e l'AI è fondamentale per ottenere e aggiornare questi insight in modo efficiente.

Due esempi concreti illustrano l'applicazione dei dati sintetici. In un caso, per sviluppare un modello AI capace di leggere e interpretare immagini di fogli presenze scansionati da carta, la scarsità di immagini reali ha imposto la creazione di un ampio dataset sintetico che simulasse layout, font, scrittura, rumore visivo e imperfezioni comuni. Questo ha permesso di addestrare e testare un modello robusto anche con dati limitati. Un altro esempio riguarda lo sviluppo di un modello per stimare l'elasticità della domanda rispetto al prezzo in un'azienda produttrice di beni industriali. La mancanza di dati storici sufficienti per specifiche combinazioni prodotto-cliente ha reso necessaria la generazione di un dataset sintetico, partendo dalle distribuzioni osservate e simulando andamenti, comportamenti d'acquisto e scenari ipotetici. Ciò ha migliorato la capacità predittiva del modello anche in situazioni con dati reali scarsi.

Strumenti che portano l’AI anche in ambiti dove i dati non sono “big”

In un mercato sempre più competitivo e dinamico, la qualità e la disponibilità dei dati emergono come elementi fondamentali non solo per alimentare l'intelligenza artificiale, ma anche per generare insight affidabili e potenti e abilitare azioni rapide. Per le aziende italiane che mirano a sfruttare il potenziale dell'AI per migliorare l'efficienza e stimolare innovazione e sviluppo, affrontare la sfida dei dati – sia reali che sintetici – è non solo necessario, ma strategicamente indispensabile. Le soluzioni di generazione di dati sintetici rappresentano un fattore abilitante per trasformare le sperimentazioni in applicazioni produttive con un reale vantaggio per il business.